No more Scraping: Google JavaScript-Pflicht verändert SEO & KI-Suche

Heiße News von Search Engine Roundtable: Google hat die Spielregeln verändert! Wer ohne JavaScript sucht, bekommt keine Ergebnisse mehr. Eine unscheinbare Änderung? Nein – das könnte die gesamte Suchlandschaft umkrempeln.

Nicht nur SEO-Tools und Scraper haben ein Problem, sondern auch KI-gestützte Suchmaschinen wie Google SGE, Perplexity AI oder ChatGPT-Browsing.

Was steckt dahinter? Und was bedeutet das für Generative Engine Optimization (GEO) – die Optimierung für KI-Suchmaschinen? Lass uns das gemeinsam durchleuchten.

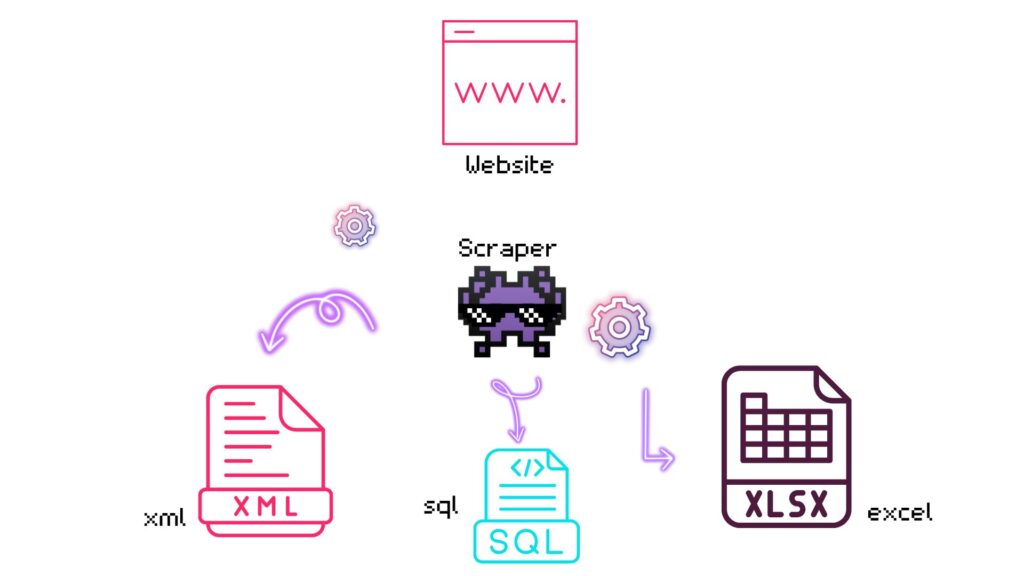

Scraper vs. Crawler – Was ist was?

Bevor wir zu technisch werden, klären wir erstmal die Basics:

Was ist ein Scraper?

Ein Scraper ist ein automatisiertes Programm (Bot), das gezielt Daten aus Webseiten extrahiert. SEO-Tools wie Semrush, Ahrefs oder Sistrix nutzen Scraper, um Google-Suchergebnisse zu analysieren – zum Beispiel Ranking-Daten, Titel und Meta-Beschreibungen.

Wie unterscheidet sich ein Scraper von einem Crawler?

Ähnlich wie ein Crawler (z. B. Googlebot), der das Web durchforstet und Seiten für Suchmaschinen indexiert, durchforstet ein Scraper Webseiten – aber nicht zur Indexierung, sondern um gezielt Daten zu sammeln.

| Begriff | Definition | Beispiel |

|---|---|---|

| Crawler | Ein Bot, der das Web durchsucht und Webseiten für Suchmaschinen indexiert. | Googlebot (Googles eigener Crawler) besucht deine Seite, um sie in den Index aufzunehmen. |

| Scraper | Ein Bot, der gezielt Daten aus Webseiten extrahiert, aber nicht zum Zweck der Indexierung. | Ein Tool wie Ahrefs oder Semrush sammelt Google-Rankings und Keywords aus den Suchergebnissen. |

So funktioniert Scraping in der Praxis:

- Der Scraper stellt eine Google-Suchanfrage (z. B. „beste SEO-Strategien 2025“).

- Er scannt die angezeigten Suchergebnisse und speichert Positionen, Titel & Beschreibungen.

- Die gesammelten Daten werden analysiert – etwa für Ranking-Überwachungen oder Keyword-Analysen.

💡👾 Bytey bringt´s on point:

Ein Scraper saugt Daten ab, ein Crawler kartiert das Web.

Scraper: Nimmt gezielt Infos aus Webseiten.

Crawler: Durchsucht das Internet für Suchmaschinen.

Was steckt hinter der JavaScript-Pflicht?

Ab hier wird’s richtig spannend! Warum setzt Google plötzlich auf JavaScript als Zugangsschranke? Und was bedeutet das für SEO, GEO und die KI-gestützte Suche? Lass uns das mal entwirren.

1. Schutz vor Scraping – Google verschließt die Daten

SEO-Tools wie Ahrefs, Semrush oder Sistrix nutzen Scraper, um Google-Suchergebnisse zu analysieren. Doch genau das wird jetzt deutlich schwieriger:

- Ohne JavaScript gibt’s keine Suchergebnisse – klassische Scraper sehen eine leere Seite.

- Herkömmliche Crawler scheitern an der neuen Barriere – Google blockt automatisierte Anfragen konsequenter.

Was bedeutet das für SEO & GEO?

- Rank-Tracking wird schwieriger. Wer Google-Daten auslesen will, muss auf neue Methoden setzen.

- KI-gestützte SEO-Analysen brauchen neue Datenquellen. Scraping allein reicht nicht mehr aus.

2. Google setzt auf ein geschlossenes System

Der Suchgigant hat bereits mehrere Dienste wie Google Flights und Google Trends gegen Scraping angeschottet. Jetzt geht es an die allgemeine Suche.

- Google möchte, dass Nutzer und Unternehmen direkt auf seine Plattform angewiesen sind – nicht auf externe Tools.

Meine Meinung zur Bedeutung für GEO:

- Wer in generativen Suchergebnissen (Google SGE, Perplexity AI) auftauchen will, muss seine Inhalte anders optimieren.

- E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) wird wichtiger als je zuvor.

- Content-Qualität schlägt klassische SEO-Optimierung.

3. Einschränkung von KI-Suchmaschinen

Googles Änderung trifft KI-Suchtechnologien besonders hart. Warum? Weil generative KI-Modelle wie Perplexity AI oder ChatGPT-Browsing kein JavaScript ausführen können – und damit auch keine Google-Suchergebnisse scrapen.

Warum ist das wichtig?

- KI-Suchmaschinen brauchen riesige Datenmengen, um relevante Antworten zu generieren.

- Wenn Google-SERPs nicht mehr als Datenquelle genutzt werden können, müssen KIs auf alternative Quellenausweichen.

Meine Meinung: Das ist die Chance für GEO!

- GEO-optimierter Content hat eine größere Sichtbarkeit.

- Hochwertige Inhalte werden für KI-Suchmaschinen wertvoller

In a 🌰 shell: Google verändert die Spielregeln – GEO wird zur Geheimwaffe!

🔥 Google schottet sich ab – wer seine Inhalte strategisch optimiert, kann dennoch profitieren.

🔥 Rank-Tracking-Tools müssen umdenken – Unternehmen auch.

🔥 Die Zukunft der Suche gehört denen, die sich anpassen.

👉 Wie bewertest du Googles JavaScript-Pflicht? Ein kluger Schachzug oder ein Problem für die Suchwelt? Diskutiere mit uns in den Kommentaren!